L’analyse de la parole au moyen de l’intelligence artificielle permettrait d’évaluer les risques de suicide, voire de le prévenir, selon le doctorant Alaa Nfissi

La parole joue un rôle clé dans la détection des pensées suicidaires. Elle est aussi essentielle à la compréhension de l’état mental et émotionnel des personnes qui les ruminent. Afin de mieux aider une interlocutrice ou un interlocuteur à traverser une période de crise, les téléconseillères et téléconseillers des organismes voués à la prévention du suicide sont formés pour analyser rapidement les variations dans sa voix.

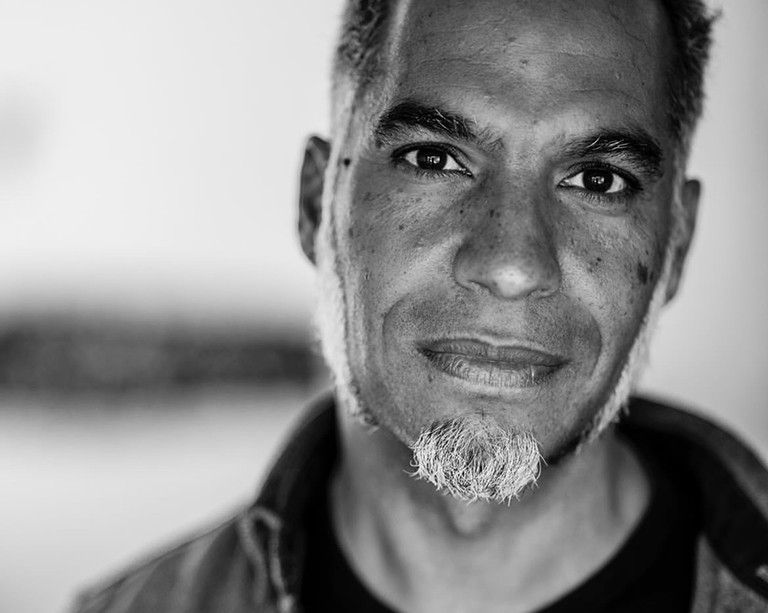

Nul système n’étant parfait, l’interprétation des paroles d’une personne suicidaire peut parfois se révéler erronée. Soucieux d’aider les intervenantes et intervenants des lignes d’urgence à évaluer correctement l’état de leur interlocutrice ou interlocuteur, Alaa Nfissi – doctorant à l’Université Concordia et membre du Centre de recherche et d’intervention sur le suicide, enjeux éthiques et pratiques de fin de vie (CRISE) – a conçu un modèle de reconnaissance des émotions dans la parole, qui utilise des outils d’intelligence artificielle pour analyser et coder avec exactitude les modulations présentes dans la voix d’une personne appelante. Selon lui, ce modèle favoriserait une amélioration de la performance du personnel d’intervention lors de situations réelles de prévention du suicide.

« Jusqu’ici, la reconnaissance des émotions dans la parole se faisait généralement à la main, explique-t-il. De fait, des psychologues de formation prenaient en note tout signal vocal témoignant d’un ressenti émotionnel – un exercice chronophage exigeant une expertise pointue. Notre modèle d’apprentissage profond relève automatiquement les caractéristiques liées à la reconnaissance des émotions dans la parole, et ce, selon une approche de bout en bout. »

Présentée pour la première fois en février 2024 à l’occasion de l’IEEE 18th International Conference on Semantic Computing en Californie, l’étude a remporté le prix du meilleur article étudiant (« Best Student Paper Award »).

Lecture instantanée des émotions

Pour élaborer son modèle, Alaa Nfissi a recouru à une base de données constituée d’appels réels acheminés à des organismes voués à la prévention du suicide ainsi qu’à une compilation d’enregistrements faits par des comédiennes et comédiens exprimant des émotions précises. Dans le cadre d’un protocole adapté à ce type de tâche, les deux ensembles ont été segmentés, puis annotés par des chercheuses et chercheurs de formation ou par les personnes ayant procédé elles-mêmes aux enregistrements.

Chaque segment était annoté de sorte à refléter un état d’esprit particulier : colère; indifférence; tristesse; ou peur, souci ou inquiétude. Les enregistrements effectués par les comédiennes et comédiens ont contribué à améliorer la couverture émotionnelle de l’ensemble de données initial, où la colère ainsi que la peur, le souci ou l’inquiétude étaient sous-représentés.

Les données ont ensuite été analysées à l’aide du modèle d’apprentissage profond d’Alaa Nfissi, étayé par un réseau neuronal convolutif et des unités récurrentes fermées. Ces architectures d’apprentissage profond servent au traitement de séquences de données extrayant des caractéristiques pointues à dépendance chronologique.

« Ici, la transmission des émotions passe par un processus temporel, indique-t-il. En nous fondant sur ce que la personne a exprimé précédemment, nous pouvons les détecter. Comme nous savons peu ou prou ce qui s’est passé et ce qui s’est dit auparavant, nous sommes mieux en mesure de détecter l’état émotionnel de cette personne à un moment précis. »

Selon Alaa Nfissi, son modèle surpasse les architectures existantes. En effet, les modèles précédents exigeaient de traiter des segments de même longueur – généralement cinq ou six secondes – et s’appuyaient sur des fonctionnalités conçues sur mesure. Le modèle d’Alaa Nfissi utilise des signaux de gestion de longueur variable et peut traiter des segments de durées différentes sans avoir à recourir à des fonctionnalités sur mesure.

L’efficacité du modèle est corroborée par les résultats obtenus. En effet, dans l’ensemble de données fusionné, il a reconnu avec précision les quatre émotions ciblées. Plus précisément, il a correctement identifié la peur, le souci ou l’inquiétude dans 82 % des cas; l’indifférence dans 78 % des cas; la tristesse dans 77 % des cas; et la colère dans 72 % des cas.

Il s’est avéré particulièrement efficace dans la reconnaissance des segments enregistrés par des comédiennes et comédiens, son taux d’exactitude allant de 78 % pour la tristesse à 100 % pour la colère!

Sur le plan personnel, ce travail revêt une grande importance pour Alaa Nfissi. C’est que pour mettre au point son modèle, il a dû analyser longuement des interventions menées par des membres du personnel d’organismes voués à la prévention du suicide.

« Bon nombre des personnes appelantes souffrent, souligne-t-il. Parfois, la simple intervention d’une téléconseillère ou d’un téléconseiller peut s’avérer cruciale. Cependant, la formation du personnel varie d’un organisme de prévention du suicide à l’autre. Alors, des téléconseillères et téléconseillers mettent plus de temps à capter et à analyser les émotions des personnes appelantes. »

Alaa Nfissi souhaite que son modèle facilite la conception d’un tableau de bord en temps réel dont les téléconseillères et téléconseillers pourront se servir dans leurs interventions auprès de personnes appelantes aux prises avec l’émotion et qui les aidera à choisir la stratégie appropriée.

« J’espère que les interventions étayées par mon modèle permettront de mieux prêter assistance aux personnes appelantes et, surtout, de les convaincre de ne pas commettre l’irréparable », ajoute-t-il.

Ont contribué à la rédaction de l’article : Nizar Bouguila, professeur à l’Institut d’ingénierie des systèmes d’information de l’Université Concordia; Wassim Bouachir, professeur à l’Université TÉLUQ et membre du CRISE; et Brian Mishara, professeur à l’Université du Québec à Montréal et membre du CRISE.

Si vous ou une personne de votre entourage envisagez de vous suicider, appelez ou envoyez un message texte à la Ligne d'aide pour le suicide au 988 ou visitez le Centre de prévention du suicide de Montréal.

Lisez l’article cité (en anglais) : « Unlocking the Emotional States of High-Risk Suicide Callers through Speech Analysis ».